A/B-тестирование — это метод, который используют для сравнения двух разных вариантов элементов веб-сайта, приложения, рекламных креативов или маркетинговых стратегий, чтобы узнать, какой из вариантов лучше.

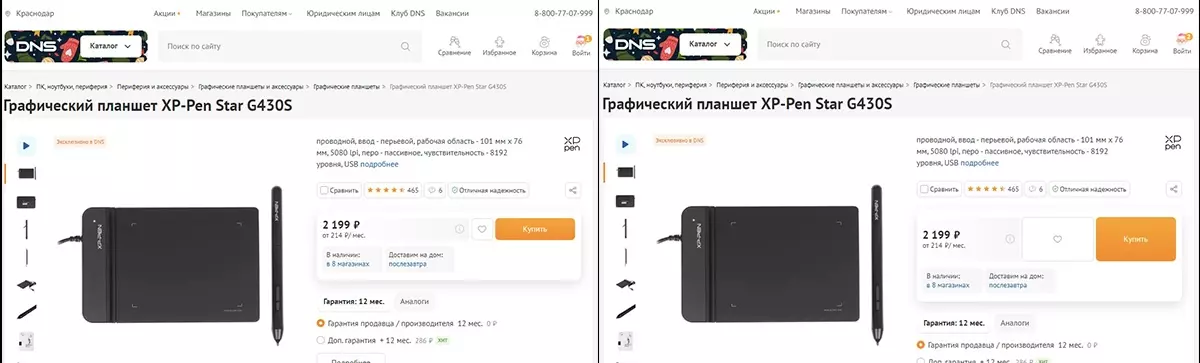

К примеру, могут сравнивать 2 разных формы обратной связи на одной странице сайта. На две страницы с разными формами можно направить определенное количество посетителей, чтобы увидеть, где форму заполняют чаще и выкатить в продакшн лучший вариант.

Иногда выбирают не из двух, а трех и более вариантов: это называется сплит-тестированием.

Представьте большой бизнес с сайтом, у которого сотни тысяч посетителей в день. В этом случае даже такая мелочь, как удаление лишних полей из формы обратной связи, может поднять конверсию и в долгосрочной перспективе увеличить выручку на миллионы рублей.

A/B-тест нужен, чтобы подтверждать или опровергать свои гипотезы касаемо оптимизации продукта. По возможности лучше отталкиваться от достоверных статистических данных, нежели работать над продуктом вручную — это все равно, что играть в рулетку. Оптимизация продукта «по наитию» легко может навредить бизнесу — все гипотезы нужно перепроверять. Это особенно касается критически важных частей продукта: например, страницы оплаты. Даже те решения по улучшению продукта, которые кажутся очевидно выигрышными, могут даже оказаться вредными, если их протестировать.

Есть множество подводных камней, которые можно не учесть и провалить тест. Простой пример: можно разделить тестируемую аудиторию на неоднородные между собой группы, от чего результаты теста утратят достоверность, даже если тест будет хорошо спроектирован. При этом, по данным VWO, 8 из 10 A/B-тестов не являются статистически значимыми, даже если они выполнены правильно. Но даже с такой «грустной» статистикой продуктовые аналитики проводят A/B-тесты — нет выбора.

Далее поделюсь методологией проведения A/B-тестов для оптимизации процентных метрик, таких как коэффициент конверсий и CTR. С помощью A/B-тестов можно оптимизировать и количественные метрики, такие как уровень среднего чека, но с ними сложнее — нужно подобрать подходящую формулу для расчета выборки. Этому придется посвятить отдельную статью, большая часть которой будет состоять из теории статистики.

Но перед тем, как погрузиться в методологию проведения A/B-тестов, расскажу о ситуациях, при которых запуск теста может принести больше убытков, нежели пользы.

Когда необходимость A/B-тестирования под сомнением

- Затраты на тест выше предполагаемой от него прибыли.

Самое первое и простое: если изменения в продукте влекут за собой несущественные изменения ключевой метрики, нет смысла тратить на него время. Ценность A/B-теста будет ясна при составлении альтернативной гипотезы с приростом метрики, выраженной в процентах. Грубо говоря, вы можете представить, насколько увеличится прибыль бизнеса, если конверсия вырастет на 2%. Станет понятно, стоит ли вообще заморачиваться над A/B-тестом.

На первый взгляд может показаться, что тесты обходятся дешево. Если декомпозировать проведение A/B-теста на мелкие задачи, становится понятно, что это трудоемкий процесс. Для проведения одного теста нужно:

- сформулировать гипотезу,

- спроектировать тест: рассчитать размеры выборок, описать задачу, убедиться в репрезентативности выборки,

- внедрить изменения в креатив или продукт,

- провести анализ результатов теста,

- подготовить отчет,

- выкатить изменения в продакшн на всю аудиторию при подтверждении альтернативной гипотезы.

Бывает, что тестирование гипотезы обходится сильно дорого. Например, при тестировании нового программного функционала, на разработку и отладку которого могут уйти десятки трудочасов. Чтобы сэкономить на проведении теста, можно использовать метод «Fake Door». Суть данного метода в том, что в продукт добавляется не сама функция, а ее «муляж». Например, добавить в соцсеть вместо полноценного раздела с онлайн-играми страницу, при переходе на которую пользователь увидит, что игры находятся в разработке и скоро станут доступны. Если переходов на страницу будет много, станет понятно, что такой раздел будет востребованным среди аудитории.

- У продукта нет достаточно большой аудитории.

Может быть так, что репрезентативная выборка планируемого A/B-теста куда больше, чем количество посетителей сайта. Грубо говоря, для проведения теста нужно 100 000 посетителей, а на сайт заходит всего 1 000 уникальных посетителей в день. Получится, что тест придется проводить 100 дней. В этом случае сроки проведения теста слишком уж долгие — большинство A/B-тестов в среднем проводится в течении двух недель. Процесс A/B-тестирования подразумевает быструю отработку гипотез, одну за другой.

- Это B2B или премиум-сегмент с небольшим количеством клиентов.

В этом случае действовать нужно осторожно: клиенты этих сегментов очень требовательны, а в некоторых отраслях B2B они еще и общаются между собой. Можно столкнуться с негативом, если тестировать ценностное предложение: одним клиентам достанутся одни условия, а другим — другие. К тому же, с большей вероятностью целевая аудитория будет недостаточно большой для проведения A/B-тестов. Даже в больших продуктах, чтобы не спровоцировать негатив аудитории, тестируемый вариант показывают лишь небольшой части пользователей.

Если ваша задача или продукт не попадают под эти категории, все замечательно — можно и нужно разворачивать эксперименты.

Читайте также: Зачем нужны маркетинговые исследования и как их проводить

Этапы проведения A/B-тестирования

Методология A/B-тестов включает в себя несколько шагов, каждый из которых важен для качественного проведения эксперимента.

1 этап. Определите цель тестирования

Чтобы вложения в тесты были оправданы и несли пользу для бизнеса, начинать нужно с правильного целеполагания. Например, бизнес-целью может быть увеличение количества продаж. Для этого бизнес решает оптимизировать сайт для клиентов за счет внесения некоторых изменений в его интерфейс, которые должны увеличить число конверсий.

С течением времени ключевые цели продукта могут меняться. Например, в самом начале работы сайта команда может быть сфокусирована на увеличении количества новых клиентов. После этого фокус команды может сместиться на увеличение среднего чека или удержании клиентов, поскольку выполнение этих задач будет более выгодным для бизнеса на текущем этапе развития.

2 этап. Выберите ключевые и побочные метрики для оценки эффективности эксперимента

Эффективность тестирования будет выражаться в конкретной измеримой метрике, которая понадобится как при составлении гипотезы, так и при анализе результатов эксперимента. Чаще всего для этой цели используют метрики, которые непосредственно связаны с прибылью бизнеса: например, коэффициент конверсий или ARPU. Также при оптимизации воронки продаж могут проводиться работы над повышением показателей промежуточных метрик, таких как CTR.

Несмотря на то, что целью эксперимента является оптимизация показателя ключевой метрики, его проведение может побочно повлиять на другие метрики. Например, команда решает протестировать новую структуру посадочной страницы с целью повышения коэффициента конверсий. Результатом проведения A/B-теста может стать рост одной метрики и просадка другой: например, с ростом конверсии может упасть средний чек продажи. Анализ косвенных метрик пригодится не только в формировании новых гипотез для дальнейшего улучшения продукта, но и в оценке эффективности изменений.

Читайте также: 10 самых важных метрик продукта

3 этап. Разработайте гипотезы и приоритизируйте их

Результаты любого A/B-теста являются доказательством или опровержением заранее выстроенной идеи по улучшению. Пример: продуктовая команда SaaS-сервиса решает, что если добавить к единственному тарифу сервиса тарифы подороже и подешевле, продажи основного тарифа вырастут. Чтобы выяснить, сработает ли это в их случае, команда должна превратить идею в гипотезу для A/B-тестирования и провести эксперимент.

Качественная гипотеза должна быть конкретной, измеримой и проверяемой. Выглядеть она будет примерно так: «Изменение цвета кнопки „Купить“ на зеленый увеличит коэффициент конверсии на 2%». Это важно, потому что без измеримого показателя в гипотезе не получится рассчитать количество посетителей, необходимых для проведения эксперимента. Еще без этого не получится спрогнозировать рост прибыли, достигаемый при успешном завершении теста и внедрении изменений в продакшн. А уже без оценки предполагаемого роста прибыли не получится оценить рентабельность и целесообразность проведения тестирования.

Гипотезы должны проверять лишь одно изменение. Например, если вы считаете, что на сайте нужно поменять контент местами, перекрасить кнопки и внедрить дополнительные каналы связи, все эти изменения обязательно нужно тестировать по отдельности. Если вы проведете эксперимент над всем сразу, вы не поймете, что в итоге повлияло на изменение ключевой метрики. Из-за этого в дальнейшем вы будете генерировать некачественные гипотезы и принимать неверные решения по оптимизации продукта.

Редко когда формируется одна гипотеза: почти всегда команда генерирует много разных идей, которые подлежат проверке. Поскольку идеи конкурируют между собой, их нужно приоритизировать по предполагаемой прибыли и стоимости проведения эксперимента, чтобы начать с более дешевых и прибыльных тестов.

Для сбора гипотез нужно завести бэклог, в котором вы будете приоритизировать гипотезы и фиксировать результаты их проверки. Так все сотрудники команды смогут добавлять свои идеи в бэклог, а еще там же останется история протестированных гипотез, с которой вы не будете повторять однородные тесты.

Читайте также: Как в разы поднять конверсию сайтов и приложений

4 этап. Подготовьте тестирование

Работы над дизайном A/B-теста включают в себя расчет выборки, необходимой для проведения эксперимента, а также проверку ее репрезентативности.

Как рассчитать размер выборки для проведения A/B-теста

Размер выборки — это количество посетителей одного из тестируемых вариантов, необходимых для подтверждения или опровержения вашей гипотезы.

В интернете есть масса различных калькуляторов для A/B-тестов с целью оптимизации процентных метрик. В рунете наиболее популярен калькулятор достоверности А/B-тестирования от сервиса Mindbox.

Какие данные нужно ввести в калькулятор для расчета выборки:

- Количество вариантов. Здесь нужно указать количество вариантов тестируемых субъектов: например, посадочных страниц. Всего можно выбрать до 5 вариантов. Отмечу, что большинству проектов будет тяжело собрать достаточный объем репрезентативной выборки из-за низкой посещаемости. Если продукт посещает до 10 000 человек в день, лучше остановиться на тестировании двух вариантов – если тестировать больше, велика вероятность, что в дизайн сплит-тестирования закрадутся ошибки.

- Средний показатель. Сюда нужно вписать усредненный показатель ключевой метрики, которая будет оптимизироваться за счет проведения теста. Например, это может быть коэффициент конверсии или процент открываемости электронных писем. Этот показатель берется из аналитических данных, например из Яндекс.Метрики. Если продукт новый и таких данных нет, их можно взять из маркетинговых исследований рынка или анализа конкурентов.

- Ожидаемый абсолютный прирост. Здесь пишется процент, на который ожидается прирост ключевой метрики. На скриншоте указан 1 % – это значит, что изменения в тестируемом субъекте должны повысить конверсию на 1 %. То есть, была конверсия в 3 %, мы внесли изменения в лендинг и ожидаем, что эти изменения поднимут конверсию до 4 %.

- Достоверность. Этот показатель означает, что результатам A/B-теста можно верить в 95 % случаев, а в 5 % возможное подтверждение гипотезы будет лишь случайностью. При желании этот показатель можно поднять до 99 %, но тогда требуемая выборка может сильно вырасти. Иногда такую выборку собрать очень проблематично, поэтому приходится проводить тесты с достоверностью в 95 %. Вообще, «достоверность» в этом калькуляторе – это «перевернутый» статистический показатель p-value, который как раз часто указывают в значении 0,05.

- Мощность. Это вероятность того, что данные теста будут статистически значимыми, если проверяемая гипотеза не подтвердится. То есть, если 2 тестируемых варианта не покажут существенной разницы, в 80 % случаев можно будет с уверенностью сказать, что оптимизация не принесла результата. Проще говоря, это как показатель «достоверности», только наоборот: мощность показывает вероятность достоверности теста, если он не показал положительный результат. Показатель мощности тоже можно поднять до 99 %, но тогда размер выборки также вырастет.

Как убедиться в репрезентативности выборки

Аудитория в выборке для теста должна быть максимально схожа по характеристикам с общей аудиторией продукта — тогда она будет репрезентативной. Например, если в вашей выборке будет большой перекос в сторону пользователей старше 30 лет, что несвойственно для общей аудитории, выборка не будет считаться репрезентативной. Вы сами выбираете, по каким срезам выборка должна быть репрезентативной, чтобы тест был достоверным — единого рецепта тут нет.

Дополнение: если вы тестируете определенный сегмент аудитории, например, пользователей мобильной версии сайта, аудитория выборки должна соответствовать общей аудитории пользователей мобильной версии.

Чтобы убедиться в репрезентативности выборки, можно провести A/A-тест. Вы можете собрать две контрольные группы и показать им одну и ту же версию продукта, чтобы посмотреть, насколько сильно между ними будут различаться показатель ключевой метрики. Если различий не будет, скорее всего, выборку можно считать репрезентативной. Также, чтобы сэкономить время тестирования, можно провести A/A/B-тест, при котором две аудитории увидят одинаковый вариант, а третья — измененный.

5 этап. Проведите тестирование

В случае с сайтом, для проведения A/B-теста можно использовать инструмент «Эксперименты», который доступен в Яндекс.Метрике. Для тестирования мобильных приложений используют инструменты мобильной аналитики, такие как Amplitude. У сервисов есть официальные руководства по настройке A/B-тестов — не буду рассказывать о работе с инструментами, сразу перейду к методологии.

Читайте также: Полный гайд по Яндекс.Метрике

Дизайн A/B-теста будет отличаться от специфики продукта, особенностей аудитории и целей тестирования — единой формулы тут нет. Поэтому расскажу о распространенных ошибках, которые делают тесты недостоверными. Чтобы результатам теста можно было верить, нужно просто не допустить эти ошибки.

Распространенные ошибки, которые допускают при проведении A/B-тестов

- Выбор конечных точек после проведения тестирования. Ключевые метрики нужно определять перед запуском теста. В противном случае можно выявить существенные изменения в метриках уже после проведения A/B-теста и решить, что они вызваны изменениями в продукте. Такие изменения в метриках будут лишь гипотезами для проведения новых A/B-тестов, но точно не следствием прошедшего теста.

- Игнорирование временных факторов. Бывает, что при небольшом объеме выборки A/B-тест можно закончить за день. Так делать нельзя, потому что велик риск «напороться» на сезонное поведение пользователей. Поэтому тест проводят в течение более длительного времени: чаще всего, на протяжении двух недель.

- Проблема «подглядывания». Если постоянно наблюдать за результатами теста, можно увидеть, что альтернативный вариант работает лучше и закончить тест досрочно. Такой результат скорее всего будет искажением, которое исчезнет при более длительном проведении теста. За ходом теста можно «подглядывать», но тест нельзя останавливать до запланированного окончания.

- Технические ошибки. Если одна или обе тестируемые группы показывают аномально низкие или высокие результаты, это будет связано с багами, допущенными в разработке теста. В этом случае A/B-тест нужно остановить, протестировать, устранить ошибки и запустить заново.

- Релиз новых функций или нового дизайна продукта во время теста. Такие изменения скорее всего повлияют на ключевые метрики, которые будут отслеживаться во время проведения A/B-теста. Если на время проведения A/B-теста запланированы обновления продукта, они не должны затрагивать тестируемую область или аудиторию.

После того, как тест успешно проведен, остается проанализировать его результаты.

6 этап. Проведите анализ и зафиксируйте результаты A/B-теста

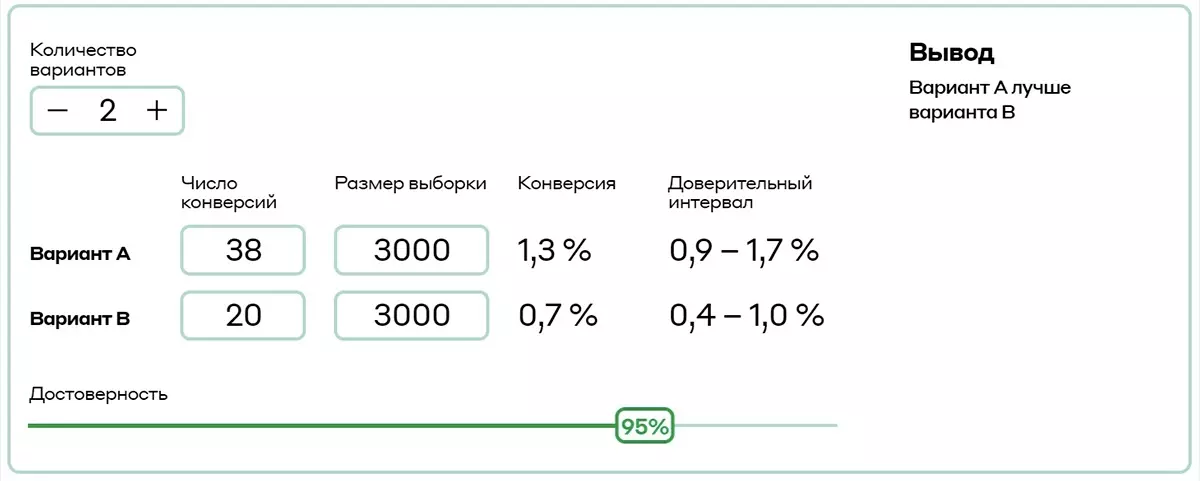

Для анализа результатов A/B-теста можно использовать тот же калькулятор от Mindbox.

Этот калькулятор еще проще, чем калькулятор для расчета выборки. Вам нужно указать количество тестируемых вариантов, размер выборки для каждой из групп, числа конверсий и общий показатель достоверности. После этого калькулятор рассчитает процент конверсий и сформирует вывод, основанный на результатах A/B-теста. Выводов может быть три: альтернативный вариант работает лучше, работает хуже или работает примерно так же.

Даже если альтернативный вариант не дал существенных изменений, нельзя сказать, что тест проводился зря.

Почему отсутствие изменений — тоже хороший результат:

- Вы проанализируете изменения в побочных метриках и выявите идеи для новых гипотез.

- Вы «закроете гештальт», отработав одну из гипотез.

- Вы получите аналитический опыт, за счет чего ваши следующие тесты с большей вероятностью принесут ощутимый результат.

Если остались вопросы, делитесь ими в комментариях 👇

на журнал