У Google более 200 алгоритмов ранжирования, каждый из них оказывает влияние на поисковую выдачу. Некоторые из алгоритмов Google могут наказывать сайты за плохие показатели оптимизации, понижая их в поисковой выдаче. Самые грозные из алгоритмов могут накладывать серьезные санкции, вплоть до удаления сайта из поисковой выдачи.

Расскажем все о основных алгоритмах Google и их фильтрах пессимизации в поисковой выдаче. Как понять, что сайт под фильтрами и как из-под них выбраться — обо всем в этой статье.

Песочница (Sandbox)

«Песочница» — «мифический» фильтр Google. Дело в том, что по официальным заявлениям компании, такого фильтра не существует. При этом, SEO-оптимизаторы небезосновательно подозревают Google в утаивании этого фильтра еще с 2004 года.

«Песочница» не дает молодым сайтам полностью проиндексироваться и занять хорошие позиции в поисковой выдаче Google. Под действием фильтра молодой сайт получает сильно урезанное количество посетителей из органической выдачи. По наблюдениям специалистов, молодой сайт может находиться в «Песочнице» до года с момента его создания.

SEO-оптимизаторы предполагают, что на момент нахождения в «Песочнице» сайт анализируется поисковыми алгоритмами и асессорами Google. Молодой сайт проходит комплексную проверку на отсутствие нарушений, техническую оптимизацию и качество контента.

Как обойти санкции «Песочницы»

SEO-оптимизаторы нашли способ перехитрить алгоритм. Опытным путем выяснились критерии, на которые реагирует «Песочница»:

- возраст доменного имени (более 2 лет);

- хорошая внешняя ссылочная масса;

- хороший показатель показатель траста сайта.

Чтобы пройти «Песочницу» естественным путем, нужно ждать полгода-год. Чтобы не ждать выхода из «Песочницы» долгое время, критерии алгоритма можно искусственно привести к нужным показателям. Есть 2 способа, как это сделать.

1. Купить домен с историей.

Можно вообще не попасть в «Песочницу», если приобрести домен, который не сняли с регистрации. На этом домене вы сможете сделать свой новый сайт, при этом у сайта останутся характеристики, которые позволят ему миновать «Песочницу». Нужно, чтобы дроп-домен проходил по критериям «Песочницы» и у него не было плохой истории. Мы подробно рассказали о правильном подборе дроп-доменов в статье про SEO-продвижение в Google.

2. Использование дроп-доменов в качестве донора траста.

Другой способ применения дроп-домена — использование его в качестве донора. В этом случае SEO-оптимизатор настраивает ссылки на дроп-домене, которые ведут на продвигаемый сайт. Более авторитетный дроп-домен ссылается на молодой продвигаемый сайт, за счет чего передает молодому сайту свой траст и ссылочный вес.

Панда (Panda)

«Панда» — алгоритм поисковой выдачи Google, который следит за качеством контента. Ранее «Панда» был санкционным фильтром, но с 2016 года стал частью общего алгоритма Google — Core Algorithms. «Панда» — грозный алгоритм, под санкции которого попадают откровенно плохие по содержанию сайты.

Список нарушений, за которыми следит «Панда»:

- неуникальный контент;

- дублирование контента на разных страницах одного сайта;

- избыточное использование ключевых слов (переспам);

- малое соотношение контента к исходящим ссылкам;

- большое количество рекламы на сайте;

- плохие поведенческие характеристики на страницах с контентом;

- большое количество страниц, нерелевантных заголовку;

- «пустые» страницы с минимальным количеством контента;

- большое количество страниц с кодом ответа 404, на которые ссылается сайт.

Под влиянием «Панды» сайт может потерять позиции в Google как по определенным страницам, так и полностью. Алгоритм страшен своим негативным эффектом, от которого сложно избавиться. В запущенных случаях с момента устранения нарушений до восстановления позиций может пройти не менее года.

Как понять, что сайт попал под санкции «Панды»

В первую очередь, сайт должен соответствовать негативным критериям, за которыми следит алгоритм. Сайты, на которые накладывают санкции данного алгоритма, существуют в запущенном состоянии достаточно долгое время, после чего резко проседают в органическом трафике.

Пострадавшие сайты получают резкое снижение позиций в поисковой выдаче Google по определенным страницам, либо по всем страницам сайта. Также большое количество страниц на сайте может в один момент пропасть из индексации. Небольшой подъем органического трафика перед последующим падением — еще один критерий санкций алгоритма, который отмечают SEO-оптимизаторы.

Как выйти из-под действия фильтра

1. Проведите полный аудит сайта на предмет нарушений, за которыми следит алгоритм.

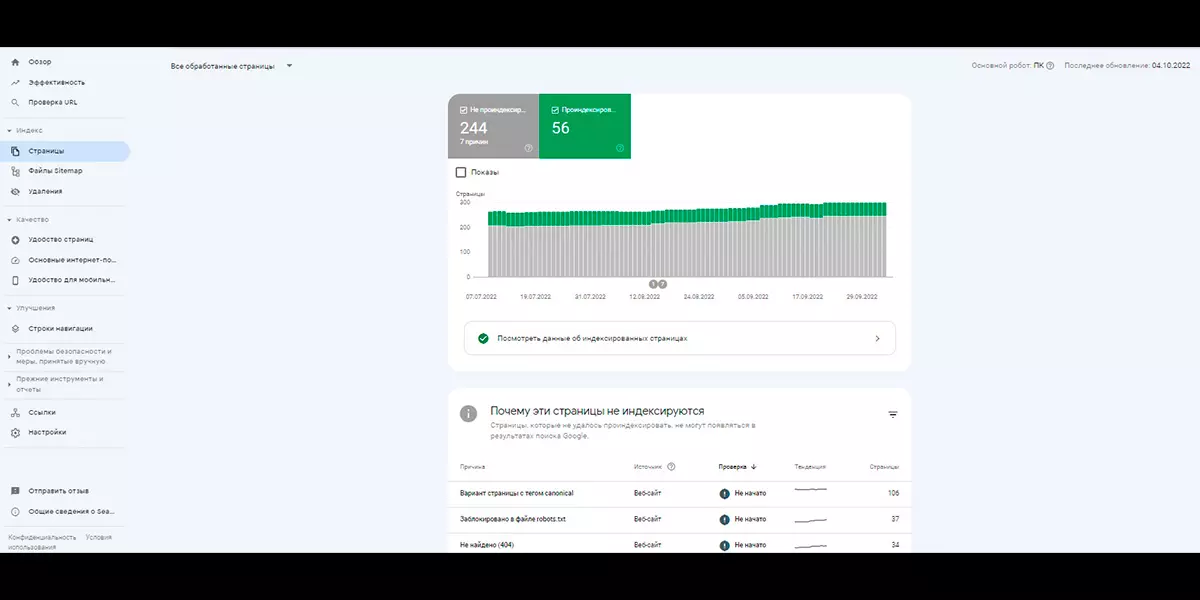

Для начала проверьте индексацию страниц вашего сайта в Google Search Console / Индекс / Страницы. В инструменте можно сформировать список с URL-адресами страниц, которых нет в поисковой выдаче Google. Для удобства список страниц можно экспортировать в формате XLS, либо CSV.

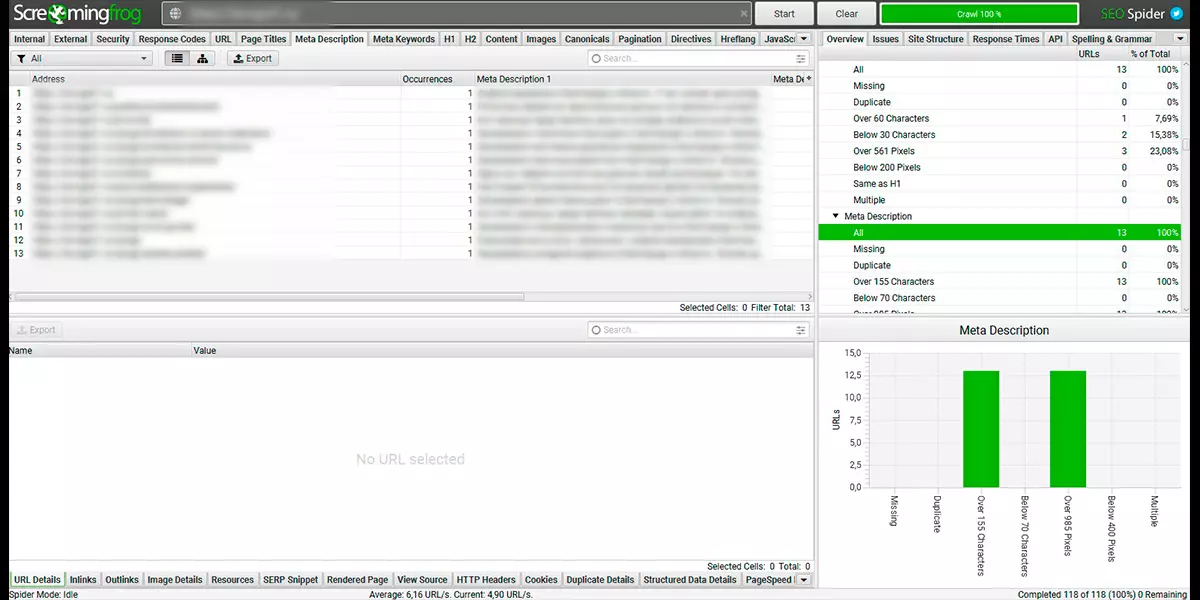

Для полноценного аудита сайта на технические аспекты, за которыми следит «Панда», используйте веб-краулер. Веб-краулер — это SEO-программа, которая сканирует сайт подобно поисковым роботам Google. Веб-краулер понадобится, чтобы оценить релевантность мета-тегов к общему контенту страницы, дубли мета-тегов и действующие страницы с кодом ответа 404. Пример подобного сервиса — Screaming Frog, можете использовать его, либо любой другой сервис.

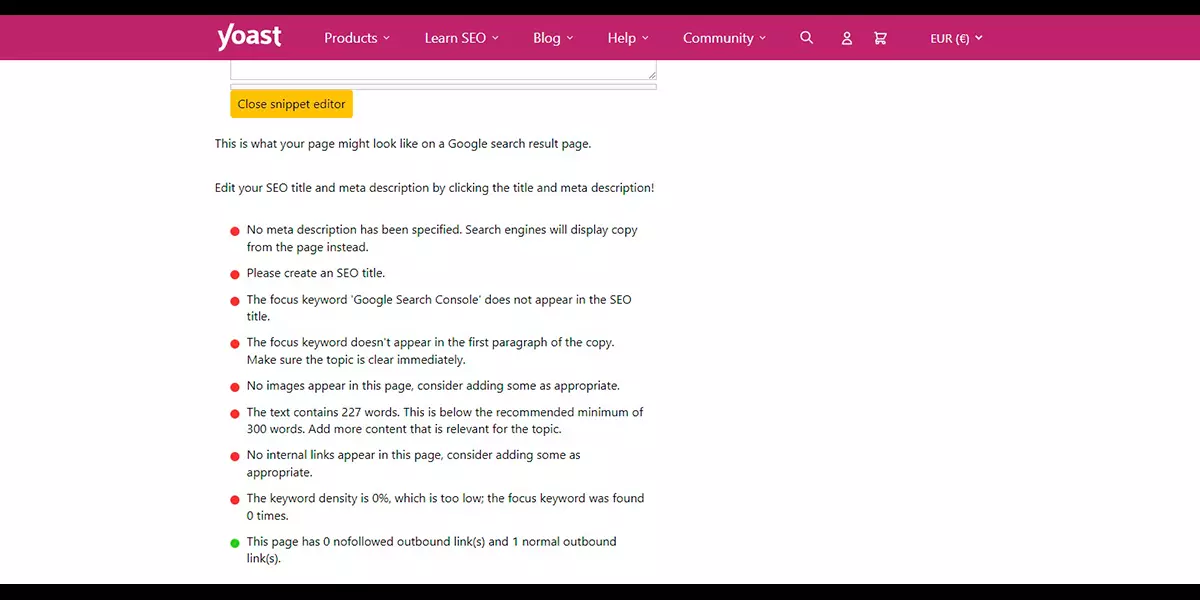

Проверить текстовый контент на переоптимизацию поисковыми ключами также можно с помощью специальных сервисов. К примеру, можно использовать Real-time Content Analysis от Yoast.

2. Устраните проблемы и оптимизируйте контент согласно критериям E-A-T.

Чтобы выйти из-под санкций Google, нужно провести масштабные работы по оптимизации контента. Постарайтесь не просто исправить недочеты, а поднять контент на качественно новый уровень, оптимизировав его под критерии E-A-T. Вы можете прочесть про критерии E-A-T в нашей статье про оптимизацию сайта под Google, либо в официальном гайде. Таким образом, вы получите больше шансов быстрее выйти из-под санкций и занять хорошие позиции в поисковой выдаче.

3. Отправьте исправленные страницы в Google Search Console на перепроверку.

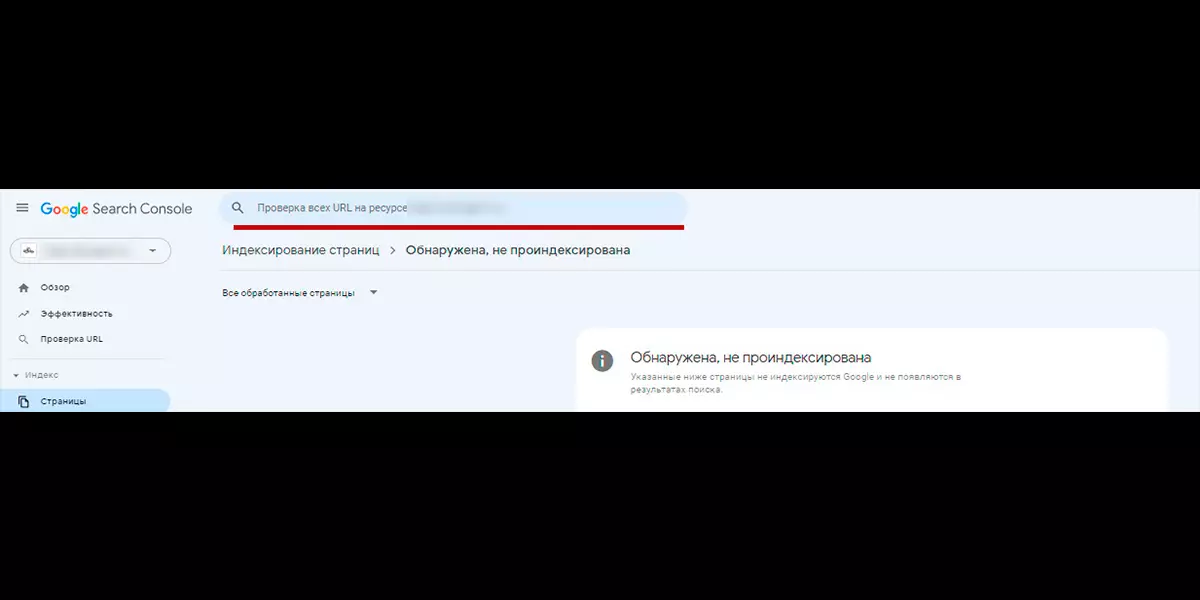

После того, как вы исправили все недочеты, отправьте оптимизированные страницы на перепроверку в Google Search Console. Воспользуйтесь инструментом «Проверка всех URL на ресурсе», отправив туда все страницы на повторную проверку.

Если вы не видите восстановление показателей органического трафика, при этом хорошо оптимизировали контент, отправляйте URL на повторную проверку раз в месяц. Напомним, что главная оружие алгоритма «Панда» — длительное снятие санкций.

Пингвин (Penguin)

Google создал «Пингвин» как инструмент для борьбы с некачественной ссылочной массой. Этот алгоритм, как и «Панда», изначально функционировал отдельно, а в 2016 году стал частью общего поискового алгоритма Google.

Поскольку ссылочный вес — один из решающих факторов ранжирования в Google, поисковой системе особенно важно отслеживать попытки недобросовестного ссылочного продвижения.

Признаки недобросовестного линкбилдинга, которые отслеживает «Пингвин»:

- резкий прирост внешней ссылочной массы;

- ссылки с сайтов, либо страниц, которые не совпадают по тематике с продвигаемой страницей;

- ссылки с сайтов с недопустимым контентом (мошеннические сайты, сайты с вирусами, сайты взрослой тематики);

- ссылки с сайтов с высоким показателем спама;

- большое количество «битых» ссылок, которые ведут на несуществующие страницы продвигаемого сайта;

- ссылки с нерелевантным анкором;

- ссылки с переоптимизированным анкором.

В отличие от «Панды», «Пингвин» ограничивается санкциями лишь на проблемные страницы сайта. Поисковая система обесценивает мусорные ссылки, а страница-адресат теряет позиции в выдаче Google. При этом, при регулярных попытках недобросовестного ссылочного продвижения сайт может попасть под ручные санкции от асессоров Google.

Как обезопаситься от санкций «Пингвина»

1. Отслеживать внешнюю ссылочную массу.

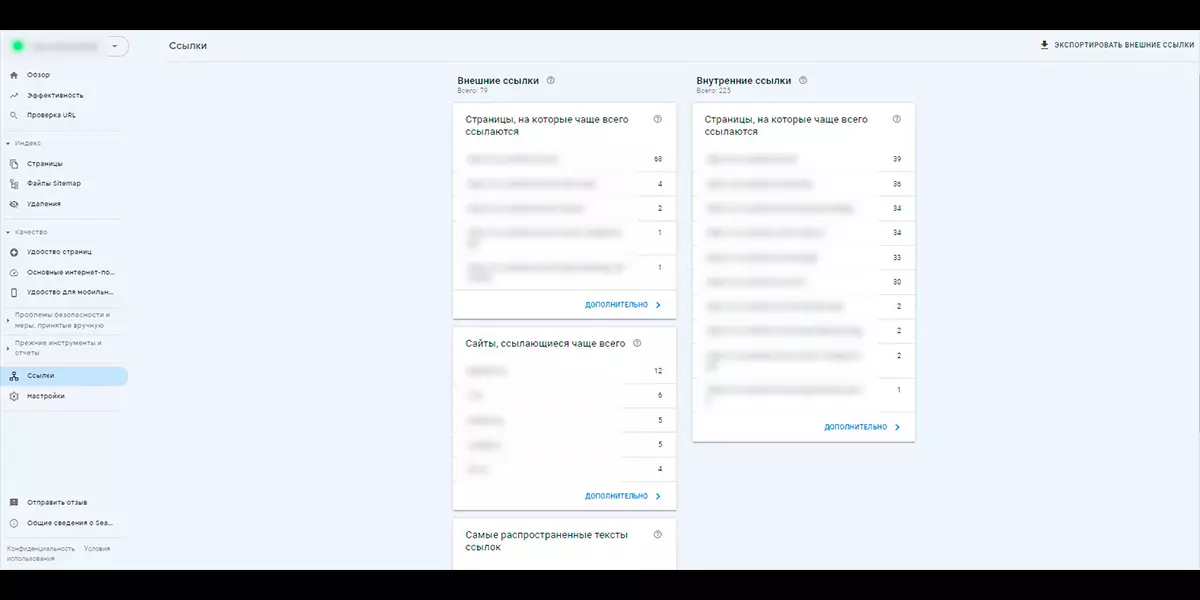

В Google Search Console есть инструмент, который позволяет отследить внешние ссылки. Там можно посмотреть: какие сайты ссылаются на ваш сайт, на какие ссылки эти сайты ссылаются, какие анкоры используют

SEO-оптимизаторы отслеживают внешнюю ссылочную массу при помощи специальных SEO-инструментов. За рубежом используют Ahrefs — сервис, который анализирует ссылочную массу доменов. Данный сервис недоступен в России, но есть альтернатива — CheckTrust.

CheckTrust, как и Ahrefs, анализирует ключевые показатели, по которым оценивают качество внешней ссылки: траст, спам и отсутствие санкций со стороны поисковых систем. Единственное отличие — CheckTrust не формирует список внешних ссылок, как это делает Ahrefs, но вы можете сделать выгрузку внешних ссылок из Google Search Console.

2. Сообщать Google о некачественных внешних ссылках.

Вы можете передать Google URL-адреса недоброкачественных внешних ссылок, чтобы эти ссылки не учитывались алгоритмом «Пингвин». Для этого у Google есть инструмент Disavow Links. Для взаимодействия с инструментом необходим авторизованный аккаунт Google Search Console, который будет подтверждать вашу принадлежность к продвигаемому сайту.

Пират (Pirate)

Алгоритм «Пират» понижает в поисковой выдаче страницы, либо сайты, на которые регулярно жалуются за нарушение авторских прав. Особо злостные сайты-нарушители полностью удаляются из поисковой выдачи Google.

Прежде всего, под фильтр попадают сайты, которые нелегально размещают авторский контент, например, пиратские онлайн-кинотеатры. Нарушители борются с алгоритмом, регулярно переезжая на новые домены и видоизменяя сайты, чтобы их не вычислили быстро.

Потребность в алгоритме возникла из-за закона DMCA, который регулирует сферу авторского права в законодательстве США. Сайты-нарушители проверяют сотрудники Google, а не поисковые роботы, поэтому данный фильтр можно назвать «ручным». При этом, «Пират» способен исключать из выдачи подозрительные страницы до ожидания проверки асессорами Google. Чтобы страницу сочли подозрительной, она должна соответствовать определенным критериям «Пирата», так же, на нее должно поступить большое количество жалоб.

Получить жесткие санкции от «Пирата» сложно, потому что поступает большое количество жалоб, которые сотрудники Google рассматривают вручную. Большое количество просьб является злоупотреблением сервиса Google по борьбе с пиратством, что осложняет работу. На данный момент, в Google поступило более 6 миллиардов обращений с просьбой фильтрации сайта из выдачи из-за пиратского контента. Можете подробнее ознакомиться с работой Google в данном направлении в их официальном отчете.

Как пожаловаться в Google, если ваш контент незаконно размещен в интернете

В данном случае можно воспользоваться сервисом Google: «Удаление содержания из Google». Среди прочих функций, там есть возможность отправить запрос на удаление контента, если он нарушает авторские права. Запросить удаление контента можно не только из поисковой выдачи Google, но и из сторонних сервисов компании, например YouTube.

Чтобы воспользоваться сервисом, необходимо дать Google максимум информации о нарушении, заполнив специальную форму. От качества обращения зависит реакция компании, поскольку в Google поступает много «мусорных» запросов, которые не соответствуют действительности. По словам Google, если запрос корректный, в среднем они рассматривают его в течении 6 часов.

Опоссум (Possum)

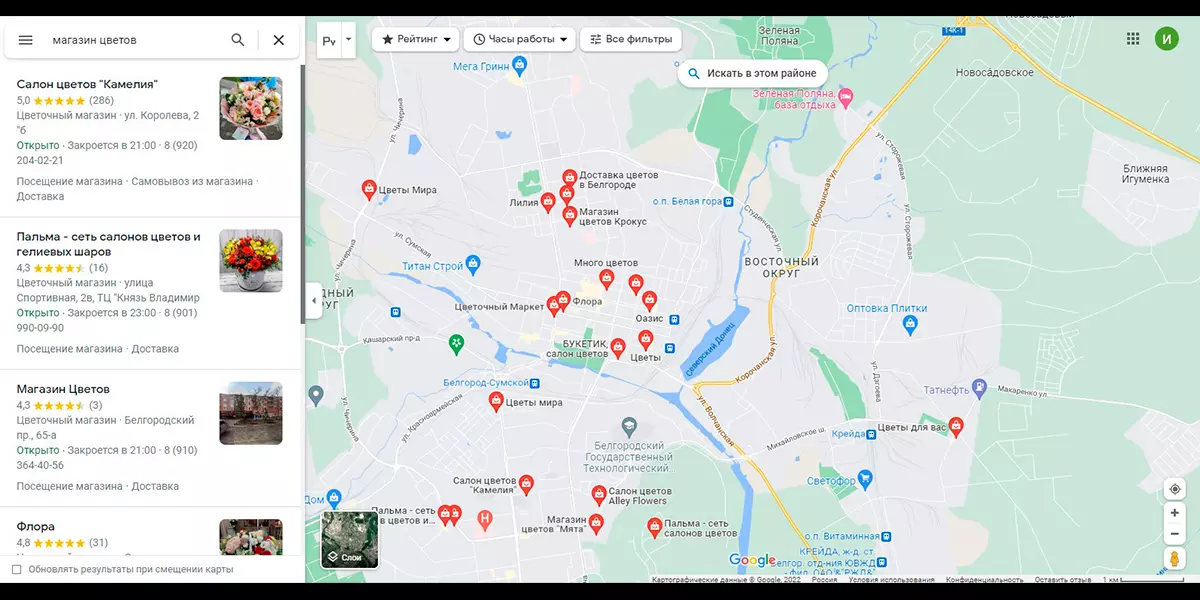

Алгоритм «Опоссум» регулирует региональную выдачу в Google. Его цель — формирование корректной выдачи локального бизнеса в поиске Google и Google Maps.

По большей части, «Опоссум» положительно влияет на продвигаемые сайты. Алгоритм обеспечивает локальным бизнесам более высокие позиции в поисковой выдаче, если посетитель находится рядом с адресом организации. Также алгоритм влияет на карточки организации в справочнике Google Мой Бизнес.

В каком случае «Опоссум» накладывает санкции

Алгоритм понижает позиции сайтов и карточек организации в единственном случае — если они являются аффилиатами. Аффилиаты в SEO-терминологии — это копии сайтов и профилей, которые создаются для того, чтобы забить поисковую выдачу данными одной организации. На аффилиатах указывают одни и те же данные организации, что и на оригинальных ресурсах.

Фред (Fred)

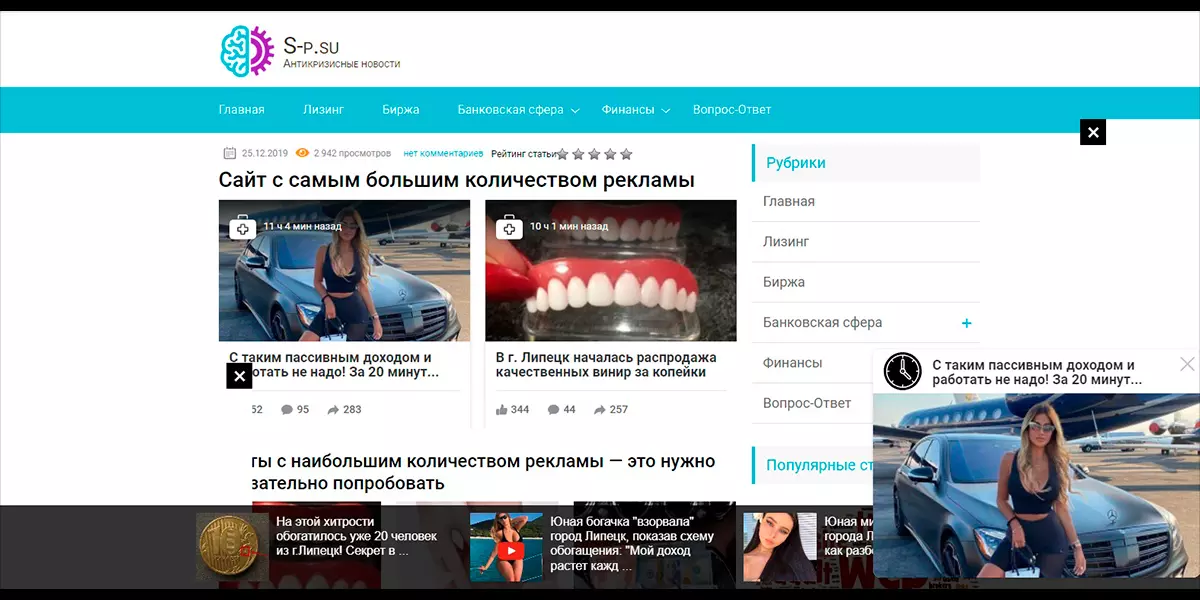

«Фред» — алгоритм, который пессимизирует выдачу сайтов с агрессивным размещением рекламы. Санкции алгоритма направлены на сайты, на которые ведут трафик исключительно для монетизации. Подобные сайты оптимизируются на скорую руку и заполняются некачественным контентом для получения органического трафика. Зачастую это новостные сайты, либо блоги без единой тематики с разрозненным семантическим ядром.

Забавный факт: название «Фред» неофициальное, его придумал Гари Иллиес, аналитик Google. Имя алгоритма зародилось в ходе переписки в Twitter с Барри Шварцем, известным SEO-оптимизатором. Гари пошутил, что все безымянные обновления алгоритмов Google можно называть «Фред». Название применяется к алгоритму, который выпустили 7 марта 2017 года.

Признаки некачественных сайтов для алгоритма «Фред»:

- Большое количество навязчивой рекламы, которая мешает просмотру контента;

- Малое количество контента на страницах;

- Контент плохого качества, который не удовлетворяет пользовательский запрос;

- Присутствие партнерских ссылок, через которые дополнительно монетизируется сайт;

- Большая доля рекламных баннеров и объявлений в соотношении к контенту.

Как не попасть под фильтры алгоритма «Фред»

Рекомендуем ознакомиться с регламентом размещения рекламы Google AdSense на своем сайте. Google AdSense — это контекстно-медийная сеть, с помощью которой можно монетизировать свой сайт. Работает так: вы размещаете на своем сайте баннеры Google, Google транслирует у вас на сайте рекламу для вашей аудитории. На требования к размещению баннеров Google AdSense можно ориентироваться, как на допустимый по меркам Google уровень рекламы.

Колибри (Hummingbird)

Алгоритм «Колибри» появился после того, как у пользователей смартфонов стал популярен голосовой поиск. В обычной речи люди не используют ключевые слова в неестественных формах, как и при голосовом вводе. Поэтому потребовался алгоритм, который смог бы улавливать смысл естественных человеческих предложений.

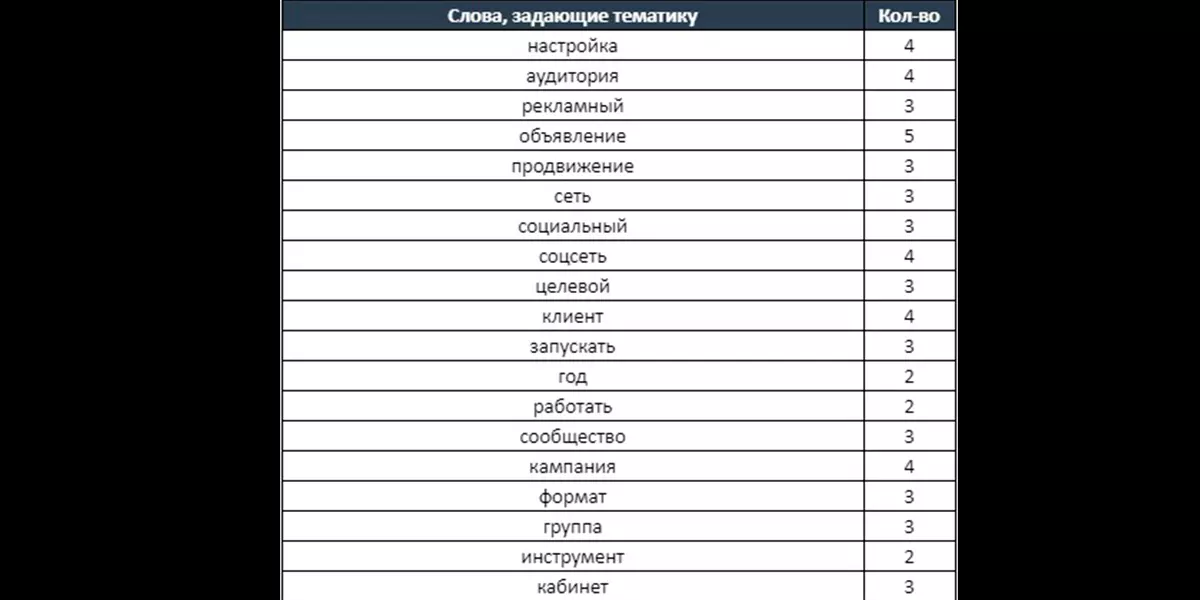

Принцип работы «Колибри» — ЛСА, то есть, латентно-семантический анализ текстов. «Колибри» понимает смысл текста по характерным словам, которые встречаются в тематике анализируемого текста. Алгоритм отслеживает частоту, плотность использования слов в тексте и ряд менее значимых показателей. По этим показателям алгоритм определяет релевантность текста пользовательскому запросу и тоже влияет на поисковую выдачу.

Алгоритм анализирует, на какие вопросы отвечает контент на сайте и сопоставляет полученные данные с пользовательскими запросами. Google научился выискивать схожие пользовательские запросы, выраженные разными словами и собирать более подходящую по смыслу выдачу.

В ответ, SEO-оптимизаторы начали применять LSI-копирайтинг. LSI — это латентно-семантическое индексирование, то есть формирование поисковой выдачи с учетом ЛСА. В LSI-копирайтинге учитывается латентно-семантический анализ алгоритма Google.

Как работать над контентом с учетом алгоритма «Колибри»

SEO-оптимизаторы дополняют технические задания требования к LSI-оптимизации текстов. В техническом задании с учетом LSI копирайтеру будут указаны слова, которые необходимо употребить в тексте определенное количество раз. Также учитывается плотность вхождения ключей: как и в SEO-оптимизации, в LSI-оптимизации с ними можно переборщить.

Специалисты используют платные SEO-инструменты, которые изучают поисковую выдачу и формируют к ТЗ требования для LSI-оптимизации. В России используют генератор ТЗ на SEO-копирайтинг от Пиксель Тулз, за рубежом — инструмент от LSIGraph.

Хорошее техническое задание помогает копирайтерам написать текст, который будет соответствовать требованиям алгоритма «Колибри».

RankBrain

Алгоритм RankBrain, как и «Колибри» был создан для лучшего понимания пользовательских запросов со стороны поисковых роботов Google. RankBrain — искусственный интеллект, который обучается на контенте из поисково й выдачи. Алгоритм понимает смысл текста и выдает пользователю более релевантный и качественный ответ на запрос.

В отличие от «Колибри», RankBrain понимает смысл отдельных слов и фраз. RankBrain понимает, в каком смысле употребляется слово в пользовательском запросе, если оно имеет несколько значений в языке. Например, в британском и американском английском есть множество слов, которые пишутся одинаково, но наделены разным смыслом. RankBrain проанализирует результаты выдачи в данной теме, после чего определит смысл слова, подходящий к запросу.

Также RankBrain следит за посетителями сайтов, отмечая их реакцию на контент. Если человек прочитал материал до конца и долго пробыл на странице, алгоритм расценит этот сигнал как хороший. Хорошие и плохие поведенческие факторы влияют на ранжирование страниц алгоритмом RankBrain.

Как работать над контентом с учетом алгоритма RankBrain

Чтобы понравиться алгоритму RankBrain, нужно предоставлять полезный и релевантный контент посетителям сайта. Контент должен полностью закрывать пользовательский запрос, а также быть правдивым и экспертным. О современных стандартах оптимизации контента под выдачу Google мы также рассказывали в нашей статье про SEO-продвижение в Google.

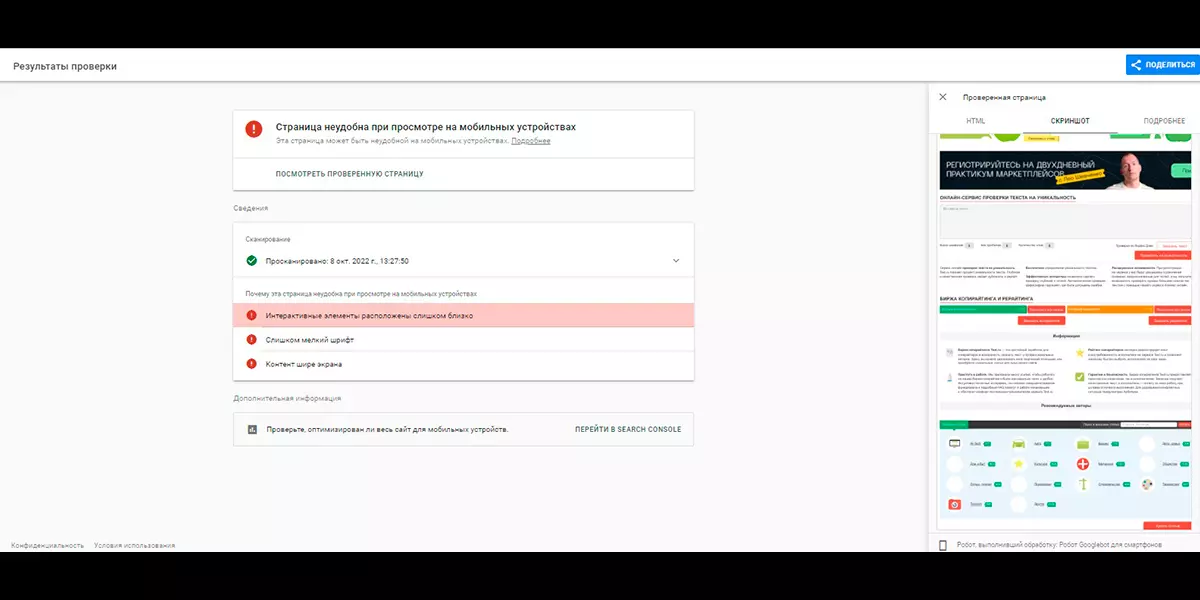

Mobile Friendly Update

Весной 2015 года прошло очередное обновление факторов ранжирования Google — тогда появился алгоритм Mobile Friendly. Алгоритм регулировал поисковую выдачу сайтов для мобильных устройств. В наши дни это важно, поскольку большая часть людей заходит на сайты не с компьютеров, а со смартфонов.

Алгоритм повышает в выдаче Google сайты, которые хорошо оптимизированы для смартфонов. Неоптимизированные сайты наоборот теряют в позициях. При этом, Mobile Friendly регулирует позиции исключительно мобильной выдачи и не трогает позиции поисковой выдачи для десктопа.

Чтобы понравиться алгоритму, сайт должен быть хорошо технически оптимизирован. На что обращает внимание алгоритм Mobile Friendly:

- верстка не содержит элементов вне экрана;

- сайт быстро открывается и не виснет;

- интерактивные элементы удобно размещены на экране;

- текст читаемый;

- нет скрытого контента.

Проверить оптимизацию сайта под мобильные устройства можно с помощью бесплатного инструмента от Google. Сервис укажет на ошибки и даст рекомендации по их устранению. Если ошибок нет, проверяемая страница оптимизирована и соответствует требованиям алгоритма.

Как оптимизировать сайт под Mobile Friendly Update

Чтобы соответствовать алгоритму Mobile Friendly, нужно качественно выполнить техническую оптимизацию сайта. Мы рассказали как это сделать в нашей статье про SEO-оптимизацию сайта для Google.

Как правило, санкции от Google застают оптимизаторов, которые не думают о посетителях своего сайта. Лишь откровенно плохая оптимизация может стать причиной серьезной просадки ресурса в поисковой выдаче. Старайтесь сделать сайт удобным продуктом и ориентируйтесь на свежую справочную информацию от Google — тогда вашу выдачу не пессимизируют.

на журнал